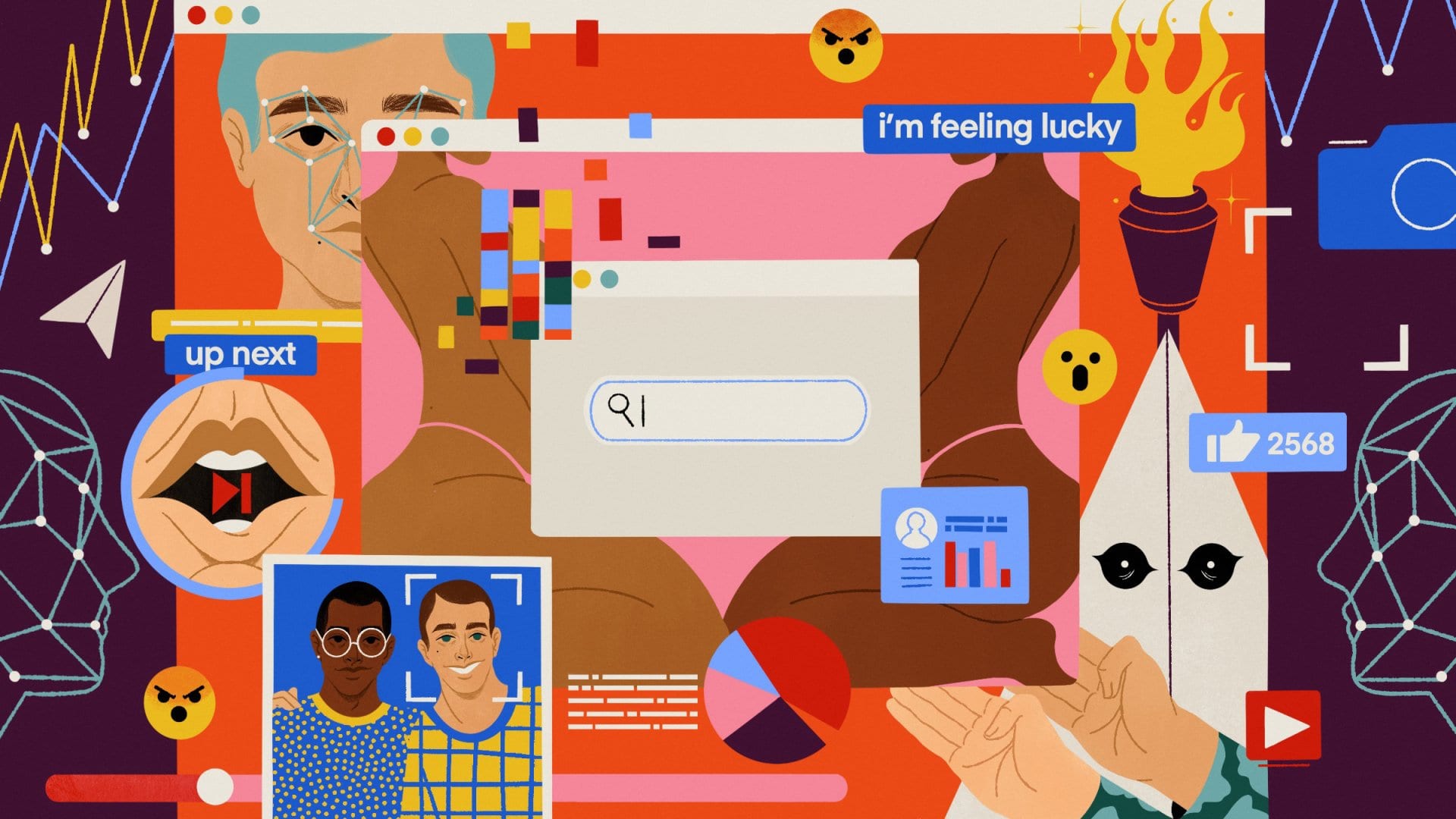

Algoritmi, la discriminazione invisibile

Ah, gli algoritmi. Stringhe di numeri e lettere che guidano l’umanità, che l’accompagnano verso la giustizia e la conoscenza neutrali e imparziali. Direttamente dal mondo della matematica, dell’informatica, dura e pura, computer che ronzano inserendo istruzioni per risolvere problemi di ogni tipo.

All’algoritmo non importa chi sei, lui va dove deve andare, usando i dati dell’utente, volontariamente o involontariamente forniti (il famoso data mining) come bussola per dare all’utente stesso proprio quello di cui ha bisogno, indipendentemente da chi sia, dal suo aspetto, dalla sua età, dalla sua etnia, dal suo status sociale. Purchè la persona abbia uno strumento cui imboccare (feed/input) i dati per ricevere un risultato (output o feedback), una soluzione, la macchina svolgerà la sua funzione; è una macchina, chi la guida non fa differenza.

Giusto?

Sbagliato: l’automazione non è affatto neutrale. Tendiamo a considerare gli algoritmi un’entità misteriosa ma inequivoca, appartenente a un mondo fatto di linee pulite, incomprensibile testo verde che scorre rapidamente su una schermata nera, macinando codici che funzionano ugualmente per tutti, passando attraverso il freddo, scientifico occhio dei numeri, ma non è così. Innanzitutto, cos’è un algoritmo?

Tanto per cominciare, non è figlio della Silicon Valley, non lo ha inventato Bill Gates, e nemmeno Alan Turing. La parola deriva dall’appellativo al-Khuwārizmī (ossia “nato nella Corasmia”) del matematico Muḥammad ibn Mūsa del 9° secolo, e designa qualunque schema o procedimento sistematico di calcolo che generi la soluzione a un determinato tipo di problema. Tale sistema è oggi comunemente gestito da un “automa”, che non è un liscio robot antropomorfo ma solo un altro algoritmo che si occupa del training, ossia di fornire indicazioni univoche per indirizzare un processo decisionale, per prevedere eventi, per riconoscere, distinguere, individuare, restituire un risultato altrettanto univoco.

I processi algoritmici però non sono imparziali come si potrebbe pensare, anzi possono essere (e tendenzialmente sono) molto discriminanti; ma come può un insieme di numeri e lettere essere razzista, o maschilista, o abilista?

Semplicemente, l’algoritmo è disegnato, costruito, messo in moto da mani umane, così come anche l’automa che lo accompagna; e l’uomo, si sa, di imparziale ha proprio poco. Le opinioni e le idee di chi crea un algoritmo saranno quasi certamente inserite al suo interno, così come quelle di un genitore vengono passate a un figlio anche senza insegnamento diretto ed esplicito. La discriminazione messa in atto dai software può essere invisibile, soprattutto se non ci riguarda direttamente, ma la sua esistenza è innegabile e intacca pesantemente le vite di chi ne è soggetto. L’algoritmo non si crea da solo, sono gli sviluppatori a decidere quali valori hanno più importanza, quali sono prioritari, quali sono positivi e quali negativi. Sì, la discriminazione è illegale, ma come stabilire se qualcuno ha commesso un crimine? È impossibile determinare le intenzioni di un algoritmo, così come non è pienamente prevedibile cosa l’algoritmo farà con le informazioni che gli vengono date.

Per fare un esempio, nel creare un algoritmo che tracci l’andamento di un dato settore di ricerca, il programmatore potrebbe inserire indicazioni che rilevino i risultati di ricercatori uomini piuttosto che quelli delle loro colleghe, semplicemente perché nella propria visione sono più rilevanti, o perché non pensa a cercare specificatamente i lavori di ricercatrici perché convinto che non ce ne siano molte. Di conseguenza, il software tenderà a mettere in evidenza le ricerche portate avanti da studiosi uomini, lasciando le studiose in ombra, pur avendo esse ottenuto pari risultati. Va ricordato che la storia umana è piena di scienziate, artiste, mediche, che semplicemente vengono messe da parte, rese invisibili e irrilevanti dalla presenza sovrastante degli uomini. La stessa fine possono fare studi in lingue diverse da quelle dello sviluppatore, nomi stranieri, altre nazionalità. Cosa vuol dire? In termini pratici, se un’azienda deve assumere ricercatori, e si appoggia a questo software per cercare candidati plausibili, e tutti quelli suggeriti dal programma sono uomini, assumere donne, che l’algoritmo non evidenzia, sarà considerato un rischio, uno spreco di fondi e risorse che, se accolto, è solo in nome del politicamente corretto.

Alcune di queste forme di discriminazione, naturalmente, potrebbero anche non essere volute, dopotutto l’umano è fallibile, anche con le migliori intenzioni, e la ricerca dell’obbiettività non è la priorità di tutti, soprattutto se si pensa di essere nel giusto. È per questo che il mondo dell’informatica ha bisogno di diversità, di programmatrici donne, trans, gay, musulmane, latino-americane, nere, indiane, nativo-americane e così via, che possano portare una visione di insieme della realtà e non solo quella sezione maschile e maschilista che è il nostro pane quotidiano.

Per capire ancora meglio la portata di questo problema e la sua gravità, può essere utile ricordare come, nel 2017, Google abbia subito un’investigazione federale in merito alla disparità salariale tra uomini e donne che portò a galla un “manifesto antidiversità” scritto da James Damore, ingegnere informatico addetto proprio alle infrastrutture di ricerca, che affermava l’inferiorità psicologica delle donne e la loro inettitudine in campo scientifico-tecnologico, con il supporto di numerosi dipendenti del colosso dell’informazione.

Umoja Noble, co-fondatrice e co-direttrice dell’UCLA Center for Critical Internet Inquiry, nel suo Algorithms of Oppression mette in luce come l’oppressione messa in atto dagli algoritmi non sia semplicemente un glitch del sistema, ma sia invece il sistema.

Il problema principale risiede nella cieca fiducia che gli utenti, tutti, di ogni età, ripongono in questi sistemi. Un bambino di sette anni, così come una persona adulta di quaranta o di settanta, potrebbe fare una ricerca su Google e tirare fuori informazioni sbagliate o estremamente di parte derivanti anche solo semplicemente dalla sintassi usata per trovare l’informazione; prenderebbe poi per buoni questi risultati, riapplicandoli dunque nella vita vera ( ebbene sì, anche noi siamo algoritmi, “immagine e somiglianza”). Lo stesso può accadere ad associazioni, società, organizzazioni, istituzioni politiche, culturali, governative, che sempre di più si appoggiano a strumenti digitali e di rete in modo ingenuo, disinformato e mal controllato.

Come evidenzia la professoressa Noble, le organizzazioni dell’informazione, biblioteche, scuole e università, nonché agenzie governative, fanno sempre più affidamento alla rete come se non vi fossero conseguenze politiche, sociali ed economiche, quando esistono persone addette a sviluppare questi algoritmi di ricerca attivamente impegnate nel renderli sessisti e razzisti, facendoli però passare come neutrali e oggettivi. Ad esempio, il software COMPAS utilizzato in alcune parti degli USA per prevedere il grado di possibile recidività, che influenza quindi sentenze e possibilità di libertà vigilata, era altamente discriminante nei confronti delle minoranze etniche, che venivano considerate più tendenti a rientrare nella criminalità, condannandoli quindi a sentenze più dure, che però li rendevano praticamente inassumibili una volta rientrati in società, portandoli, per necessità, a commettere nuovi crimini. Se come abbiamo detto, leggere l’algoritmo è impossibile, come evitare situazioni simili? Semplicemente, come proposto dal Journal of Legal Analysis (Volume 10), esaminando i dati forniti all’algoritmo e testandone gli output, e creando una legislazione e una politica adatta, che renda obbligatorio conservare e rendere disponibili tutte le componenti di un algoritmo, incluso quello di training, di modo che possano essere analizzati in modo sperimentale.

Tecnologia digitale, Internet, algoritmi, non sono neutrali. Non sono uno strumento di giustizia e verità.

E bastano poche, semplici ricerche a confermarlo. A “ragazze bianche” corrispondono immagini di belle ragazze vestite alla moda, con soffici maglioni e giubbini di pelle; “ragazze nere” rimanda direttamente ad alcune modelle in costume, o in generale ragazze poco vestite con seni prosperosi; a “ne*re” corrispondono risultati vari, tra cui “Se mi piacciono le ne*re sono razzista?” (breve ma disarmante post del febbraio 2014 di tale Bettini, che chi scrive spera si sia ripreso in questi sei anni e mezzo) e “Salvini e le ne*re tette” da Sconfinare.net, che oltre alla foto non aggiunge altro. Non che fosse necessario. Le ragazze di colore seminude sono proposte da Google Images perché sono tendenzialmente meno vestite? No, è perché chi inserisce gli indici lo fa secondo un bias che è a sua volta rinforzato dalle ricerche e dai risultati scelti dagli utenti, quindi in questo caso la feticizzazione, l’identificazione della donna di colore come oggetto sessuale, non come una ragazza con un bel maglione che mostra la manicure.

Allo stesso modo, Google si rese colpevole di aver “riconosciuto” due persone di colore con il tag “gorillas”. Questo perché, come spiegato dall’esperta di Intelligenza Artificiale Vivienne Ming, gli algoritmi di riconoscimento faticano a riconoscere le persone di colore perché sono istruiti sulla base dei contenuti di Internet, che è prevalentemente bianco; il bias di Internet replica quindi quello della società. Analogamente, nel 2009 si rese noto che le webcam Hp con modalità Face-Tracking non riuscivano a rilevare le persone di colore, e la Nikon S360 segnalava i soggetti asiatici come “ad occhi chiusi”.

“Google”afferma Noble “è un’azienda pubblicitaria, non una fonte di informazione affidabile”. I suoi proventi non arrivano dalla diffusione di conoscenza, tantomeno di informazione fattuale.

I guadagni di Google, di Facebook (che raccoglie sotto di sè Instagram e Whatsapp tra quelle note, ma anche decine di compagnie simili in India, Israele, Repubblica Ceca, Spagna, Svezia e altri), di tutti quei programmi e siti che utilizziamo quotidianamente, arrivano dalla pratica del data mining, ossia dalla raccolta e analisi dei dati che gli utenti forniscono anche, ma soprattutto, inconsapevolmente, che vengono filtrati e utilizzati/venduti al fine di migliorare le prestazioni, in una francamente sconcertante invasione della privacy dei desideri delle persone. Come recita il non troppo vecchio adagio, “Se qualcosa è gratis, la merce sei tu”.

Dopo aver appreso dagli sviluppatori, infatti, gli algoritmi imparano da noi. Si nutrono di interessi, ideologie, commenti, ricerche, contatti, conoscenze, condivisioni, registrazioni. Certo questo fornisce un servizio utilissimo e comodissimo, per ottenere quelle cose che ci piacciono e ci interessano (colonna portante di Amazon, Netflix, Spotify) ma va anche notato che l’invasione dello spazio privato diventa sempre più distopica e controllante.

Frutto del funzionamento degli algoritmi è anche l’effetto echo-chamber, allo stesso tempo porto sicuro e fabbrica di disinformazione. La “cassa di risonanza” è una bolla che si crea attorno a persone con gli stessi interessi e le stesse idee, quella che la Professoressa Wendy Hui Kyong Chun chiama omofilia, ossia l’assioma per cui dalle somiglianze nasce connessione. L’algoritmo, in questo caso, utilizza la sua capacità di darci quello che vogliamo o di cui abbiamo bisogno indirizzandoci verso altre persone che la pensano come noi. Se da un lato questo ci permette di esplorare più a fondo i nostri interessi (come è lampante ad esempio con TikTok), dall’altro lato rischia di precluderci altre facce della realtà, che possono piacerci o meno, ma che sono comunque parte di essa. “L’omofilia” aggiunge “chiude quel mondo che sembra aprire”.

È un processo che si ciba dei Big Data per riunire in categorie e sezioni di persone che condividono alcuni tratti determinanti, soprattutto gusti e disgusti. I network fomentano questi comportamenti al fine di creare tecniche di gestione, plasmazione e predizione che rendono i classici metodi di analisi dei dati sciocchezze obsolete. Si vanno a formare delle ecclesie, delle congreghe, circoli compatti, controllabili e prevedibili, come pecore in un recinto che comunicano solo tra di loro, si confrontano solo tra di loro, ripetendosi l’un l’altro le stesse idee e gli stessi concetti, come una vera e propria eco. Per alcuni, la bolla costituisce uno spazio sicuro dove poter essere sé stessi, come le persone della sfera LGBTQ+, gruppi in cui persone non binarie, o asessuali, o Asperger, o affetti da disturbi dell’umore possono trovare conforto, supporto e fonti di informazione, o gruppi di immigranti provenienti dallo stesso Paese che si aiutano l’un l’altro. Il problema è la disconnessione dalla realtà esterna.

Chi vi trova rifugio, circondandosi quasi esclusivamente di persone affini, corre il rischio di scontrarsi duramente con un mondo esterno che non corrisponde a quello in cui si è scelto di immergersi. Inoltre va tenuto conto del fatto che le echo chambers non sono solo prerogativa di minoranze discriminate, ma anche per gruppi di estremisti politici, suprematisti bianchi, no-vax, neo-nazisti, che si ritrovano tra di loro soffiando l’uno sulle idee dell’altro, convincendosi della verità delle loro posizioni, arrivando anche ad agire in funzione delle loro ideologie. È una segregazione collaborativa che, se utilizzata in modo scorretto – ossia come pozzo di verità piuttosto che come piazza, come luogo di ritrovo, può avere conseguenze serie sia in termini di alienazione dalla realtà che come giogo trainante dei sistemi di controllo a cui già siamo largamente sottoposti in un’era in cui tutto è digitale o in procinto di diventarlo, e in un momento storico in cui la vita online sta rapidamente prendendo il sopravvento su quella “dal vivo”. Troppo rapidamente perché ci si possa adattare in modo organico e consapevole. Quindi il nostro compito è informarci, dubitare, rifiutare, e spingere per avere processi e pratiche più trasparenti, più testate, e per avere più diversificazione nel mondo del programming.

La raccomandazione della Professoressa Chun è la seguente: “È fondamentale rendersi conto del fatto che lo spazio tra predizione e realtà è lo spazio per l’azione politica in cui possiamo agire. Le predizioni possono essere auto-avveranti quanto auto-cancellanti”. Sara Carolina Chisari

Sara Charlie

5/6/2021 https://www.intersezionale.com

Lascia un Commento

Vuoi partecipare alla discussione?Sentitevi liberi di contribuire!